- 欢迎使用千万蜘蛛池,网站外链优化,蜘蛛池引蜘蛛快速提高网站收录,收藏快捷键 CTRL + D

使用决策树算法进行Python决策树回归:探索决策树回归的基本原理和应用案例

决策树回归

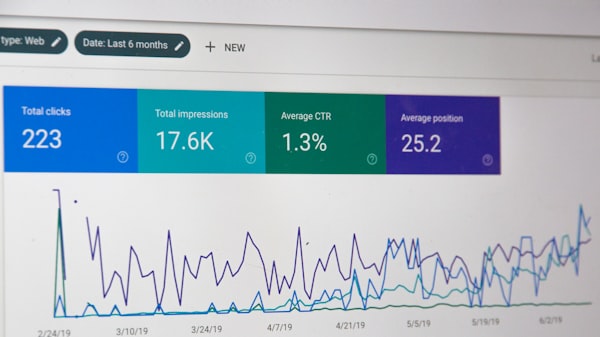

(图片来源网络)

(图片来源网络)在机器学习中,决策树是一种常用的算法,既可以用于分类问题,也可以用于回归问题。本文将讲解决策树回归的原理和在Python中的实现。

决策树回归的原理

决策树回归的基本原理是通过递归地将数据集划分为不同的子集,以最小化每个子集内的方差。具体步骤如下:

- 选择最优切分特征:通过计算每个特征对目标变量的影响程度,选择最优的特征进行切分。常用的方法有信息增益、增益率和基尼指数等。

- 切分数据集:根据选定的特征和切分点,将数据集划分为不同的子集。

- 递归构建子树:对每个子集递归地重复上述过程,直到满足停止条件(如最大深度、最小样本数等)。

- 预测和评估:对于新的输入样本,根据其特征在决策树上的路径,找到对应的叶子节点,该节点的均值或中位数作为预测值。评估回归树的性能可以使用均方误差(MSE)或均方根误差(RMSE)等指标。

Python实现决策树回归

在Python中,可以使用scikit-learn库中的DecisionTreeRegressor类来实现决策树回归。以下是一个简单的示例:

from sklearn.datasets import load_boston

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeRegressor

from sklearn.metrics import mean_squared_error

# 加载波士顿房价数据集

boston = load_boston()

X, y = boston.data, boston.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建决策树回归模型

regressor = DecisionTreeRegressor(max_depth=3)

# 训练模型

regressor.fit(X_train, y_train)

# 预测

y_pred = regressor.predict(X_test)

# 评估模型

mse = mean_squared_error(y_test, y_pred)

print("均方误差:", mse)决策树回归的优缺点

优点:

- 易于理解和解释,可以可视化展示决策过程。

- 可以处理非线性关系和多种类型的特征。

- 不需要对数据进行预处理,如归一化或标准化。

缺点:

- 容易过拟合,可以通过剪枝、设置最小样本数等方式缓解。

- 对噪声和异常值敏感,可以通过数据清洗和异常值处理改善。

- 局部最优问题,不同的初始状态可能导致不同的结果,可以通过集成方法(如随机森林)提高稳定性。

调参技巧

为了提高决策树回归的性能,可以尝试以下调参技巧:

- 调整最大深度:增加深度可以提高模型复杂度,但可能导致过拟合;减小深度可以降低复杂度,但可能欠拟合。

- 调整最小样本数:增大最小样本数可以减少过拟合,但可能导致欠拟合;减小最小样本数可以提高模型复杂度,但可能过拟合。

- 使用交叉验证:通过交叉验证选取最佳的参数组合。

相关问答FAQs

Q1: 决策树回归与线性回归有什么区别?

A1: 决策树回归可以处理非线性关系和多种类型的特征,而线性回归假设目标变量与特征之间存在线性关系,决策树回归通过递归地划分数据集来建立模型,而线性回归通过最小化残差平方和来求解参数。

Q2: 如何避免决策树回归的过拟合问题?

A2: 可以通过以下方法避免过拟合:

- 剪枝:通过预剪枝(限制最大深度)或后剪枝(删除不提升性能的子树)来简化模型。

- 设置最小样本数:增大叶节点所需的最小样本数可以降低模型复杂度。

- 正则化:使用L1或L2正则化项约束模型参数。

感谢您阅读本文,如果有任何问题或意见,请留下评论。同时,如果您觉得本文对您有帮助,请点赞、关注和分享,谢谢!

| 广告位招租-内容页尾部广告(PC) |

网络推广最新文章

- 如何安装和操作 XCache 后台控制面板?提高网站性能的利器

- 是否允许视频监控?教你如何使用app实时视频监控方案

- 如何在亚洲区申请英语域名?简单了解亚洲英语域名注册流程

- Android网络连接情况:如何检查网络连接并优化Android设备的网络性能

- 电商设计主要做什么?探究电商平台的设计重点与提升策略

- “如何架设云服务器? 一步步教你快速搭建云服务器架构”

- “为什么苹果8p微信不会爆炸?了解安全科技背后的原理”

- Linux Mint支持UEFI启动吗?完全指南和解决方案

- 如何在安卓项目中调用API?简单教程和实用技巧 安卓界面及Windows相关:了解安卓应用界面设计和与Windows系统相关的关键知识

- 安装mysql数据库服务器:简单易学的步骤指南 | MySQL安装指南

)

)

)

)